136测评:信不信由你 Facebook正在使用AI来减少滥用和偏见

Facebook首席执行官马克扎克伯格经常断言,人工智能将大幅减少数百万恶意Facebook用户所犯的滥用行为。今天在公司在旧金山举行的年度F8开发者大会上,CTO Mike Schroepfer详细介绍了其团队为实现这一雄心勃勃的目标所取得的进展。

“我们面临的挑战包括选举干扰,错误信息,仇恨言论,”施罗普费尔说。“我们必须全身心投入细节,日复一日,月复一月,年复一年地解决这些问题。”

在一个季度的过程中,Schroepfer表示Facebook取消了超过10亿个垃圾邮件帐户,超过7亿个虚假帐户,以及包含裸露和暴力的数千万个内容。他说,人工智能是所有这些类别报告的主要来源。

Facebook生产中的AI的一个具体例子是一种新的“最近邻居”算法,它在发现非法照片方面比以前的版本快8.5倍。它补充了一个系统,该系统学习了Facebook图表中所有节点的深度图形嵌入 - 网络上的数据,故事,广告和照片的集合 - 以查找可能彼此相关的滥用帐户和页面。

另一个例子是在30个方言家庭中使用93种语言训练的语言不可知的AI模型;它与其他分类器一起使用,可以同时解决多种语言问题。在视频方面,Facebook表示其显着的采样器模型 - 快速扫描视频并处理上传剪辑的“重要”部分 - 使其能够识别6500万个视频中的10,000多个不同的动作。

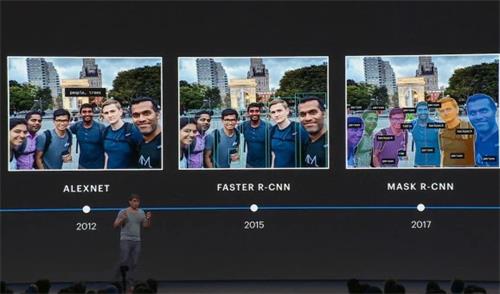

事实上,在一个包含300,000个视频和400个动作的流行基准测试中,Facebook表示其计算机视觉堆栈可以将视频分类的准确率达到82.8%,与先前领先的25%模型相比,错误率降低。“我想退后一步说,即使有这些改进,当我们看到逃避我们系统的暴力视频时,很明显视频理解还处于起步阶段,”Facebook的AI Manohar Paluri主任表示。“[但这些系统]使我们能够主动识别今天有问题的内容。”

Facebook正在大力发展称为自我监督学习的人工智能培训技术,其中未标记的数据与少量标记数据结合使用,以提高学习准确性。在一项实验中,其研究人员能够训练一种语言理解模型,与仅12,000小时的手动标记数据相比,只需80小时的数据即可进行更精确的预测。

Paluri说,像这样的人工智能模型被用于保护印度选举的完整性,印度是一个人们说22种不同语言并用13种不同文字书写的国家。“这种自我监督技术涉及多种形式,文本,语言,计算机视觉视频和语音,”他说。“工作减少了几个数量级。”

关于公平和偏见缓解的问题,Facebook应用机器学习总监JoaquinQuiñoneroCandela表示,Facebook正在使用错误校准等技术来检测和解决算法不公平问题。例如,它研究了网络的公民内容分类器 - 它检测文本片段涉及公民问题的可能性 - 根据所使用的语言得出不同的结论。

一种校准方法涉及设置Candela跨群组称为“决策阈值”的内容;如果滥用发现AI的阈值为40%,则该算法将标记内容,例如,分数超过40%。Candela表示,由于各种原因,各个数据集的得分会出现波动,Facebook研究人员需要考虑差异才能达到平价。

在某些情况下,必须创建全新的数据集。AR / VR软件的Facebook负责人Lade Obamehinti表示,Oculus团队的成员设计并收集了在不同光照条件下具有各种肤色的手动跟踪模型的语料库。未来,他们计划为Oculus品牌的耳机构建语音识别模型,其中包含跨越方言,年龄和性别维度的代表性样本。

“这是关于构建我们希望生活的未来。我们已经学到了许多真正的教训,这些教训从根本上改变了我们开发和构建新技术的方式,”Schroepfer说。“[他们]让我们意识到我们必须深刻理解,不仅要了解新技术带来的所有惊人的好处,还要了解不良,意想不到的后果,以及人们滥用这些新技术的方式。”

自去年十月英雄联盟手游在外服上线后,国内电竞圈诸多新老俱乐部纷...详情

随着时间的推进,英雄联盟手游B测已于7月20日正式开始,这也意味着...详情

BANDAI NAMCO Entertainment近日公布预定今年冬季发售的PlayStati...详情

对游玩过《闪之轨迹》系列的玩家来说十分熟悉的“战术导力器(オー...详情

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2022-04-06 | 性能评测

2021-12-27 | 性能评测

2021-12-27 | 性能评测